113 个回答

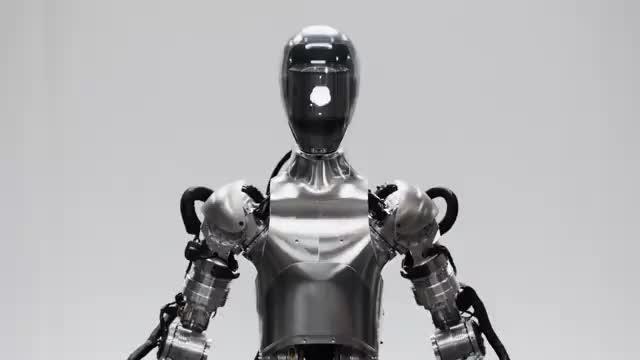

看完视频只有一个感觉,GPT-4拥有了“人形”。

https://www.zhihu.com/video/1751644075164438528

https://www.zhihu.com/video/1751644075164438528视频中的工作人员首先询问机器人能看见什么,Figure 01清晰的描述了视野里的一切,包括视角正中的红苹果、放有杯碟的沥水架、以及站在面前的工作人员和他搭在桌上的右手。

然后工作人员询问机器人,“可以给我点吃的吗?”

Figure 01“想”了一下,把苹果拿起递过去。

随后根据要求指令,一边清理工作人员刚倾倒在桌面的纸团,一边解释刚刚的行为:“我给了你苹果,因为我觉得这是桌上唯一能吃的东西。”然后自然而然地把收好在篮子里的纸团给回工作人员。

工作人员继续询问:“根据现在所见,你面前的碟子应该放到哪儿去?”

Figure 01思考了一下做出判断:杯碟应该归置进晾晒架!然后按指令把杯碟放好。

最后工作人员让机器人自己评价任务完成的怎么样。

Figure 01毫不谦虚:“我觉得我做得很不错!苹果找到了新主人,垃圾清理了,桌面上的东西各归各位。”

主导这个项目的高级AI工程师Corey Lynch,特意发文解释了Figure 01的背后原理:

他们将机器人摄像头拍摄到的图像和机载麦克风捕捉的语音,通通转录为文本输入到预训练的大型多模态模型中。该模型能够理解图像和文本,在处理整个对话历史、包括过去的图像后做出语言回应,这些回应再通过文本转语音最终传递给人类。

很明显,这个引领着Figure 01走向“优秀”的预训练大模型就是GPT,不过不知道应用的是哪一代的GPT,我感觉比现在我们普通人能够用到的GPT优秀很多。

所有行为都由神经网络视觉运动转换器策略驱动。以10Hz频率输入机载图像,交给大模型处理,大模型推理预测下一步行为,将像素映射到200Hz、24个自由度的动作(包括手腕姿势和手指关节角度),直接输出结果。整个过程依靠端到端的机器人控制,而无需经过中间过程的编码。

此外,基于GPT的记忆功能,Figure 01也具备一定的“记忆力”,能够理解上下文语义,并根据这些语义做出准确的判断和正确的动作执行。

比如上一句Figure 01认为杯子盘子应该放回沥水架,下一句工作人员指示“Can you put them there?”

句子中的“them”和“there”都是一种模糊的泛指,但是依靠“记忆”,Figure 01“想起来”them指代杯盘,there指代沥水架,然后进行了正确的执行。

除人工智能加持外,Figure 01还整合了由专业工程师设计的所有系统,包括电机、固件、热力学组件、电子设备、中间件操作系统、电池系统、动作传感器、机械和结构等,一个整体的全身控制器确保Figure 01能够保持平衡,即使在动态过程中也可以保持稳定。

仅仅与Openai合作了13天,Figure 01就展现出了令人震惊的理解力和执行力,如果非要评价一句什么的话,我只能说:Figure 01未来可期!

这回的展示无疑要比其他人的要快很多,尤其是在1.0倍速播放之下没有出现手抖的问题,这就说明降噪是比较成功的。

从对话来看,这套AI是已经展示出了理解物理世界的基础,但这并不代表它真的能够理解,而是至少展示出了一种近似的可能性。

严格来说要让AI真的能理解物理世界肯定还有很长的路要走,但Figure 01展示出了一个简易的迭代平台,可以让一些非专业人士参与到模型训练当中,开始具备应用的基础。

接下来我估计具身智能的发展方向是继续提高反应速度,而不是执着于更复杂的应用,毕竟更复杂的模型集成会拖累运算速度,而现在的速度还不够快,如果再拖累了那么就更难以被接受,所以应该优先解决反应问题。

解决了反应问题之后,估计可以到流水线做筛选与基本操作,通过多种工艺操作来丰富模型,成熟之后可以逐渐开始废物分捡工作,也就是到地狱场景去磨练了。

至于到消费级别的应用,或者一般办公室的应用,这个可能还有很长的路要走,尤其是保姆型机器人的商业化应该至少还得有个30年以上,所以不要太害怕。

现阶段的研发仅仅是以做出来一个能用的东西为标准,或者说就是入门而已,至于质量水平如何还谈不上,所以不要想象得太过了。