Como é possível ter uma comunicação confiável nos diversos sistemas de comunicações? Essa pergunta moveu Claude Shannon para que ele escrevesse sua teoria, que hoje é considerada uma das fundadoras das ciências da comunicação, e uma das maiores contribuições do século para as telecomunicações.

O que essa teoria estuda?

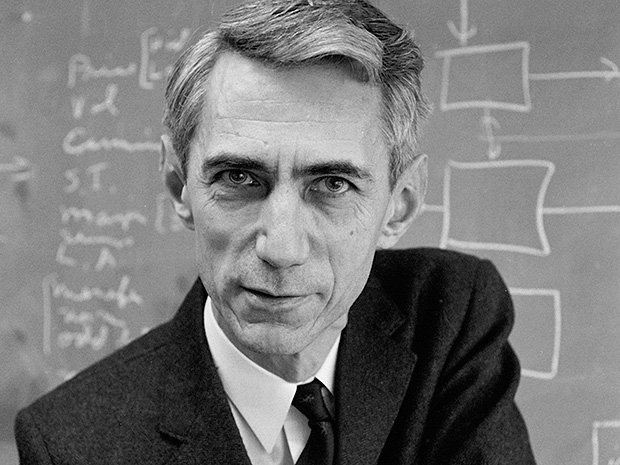

Proposta formalmente por Claude Elwood Shannon, em 1948, estuda a quantificação, armazenamento e comunicação da informação.

Suas contribuições são utilizadas na matemática, estatística, ciência da computação, física, neurobiologia, engenharia elétrica e outras. Seu impacto é crucial, por exemplo, no sucesso das missões da sonda Voyager no espaço, no entendimento de buracos negros e também no entendimento da consciência humana.

Quem foi Claude Shannon?

Nascido no dia 30 de abril de 1916 em Petoskey, Michigan, Shannon foi um matemático, engenheiro eletricista e criptógrafo estadunidense. Ele é creditado como fundador do computador digital e do projeto de circuito digital em 1937, quando escreveu uma tese demonstrando que uma aplicação elétrica utilizando álgebra booleana poderia resolver qualquer problema de lógica, com apenas 21 anos de idade, sendo aluno de mestrado no Massachusetts Institute of Technology, MIT.

Nos anos 40, durante a Segunda Guerra Mundial, Claude trabalhou em sistemas de controle de fogo e criptografia, nos Laboratórios Bell, chegando a trabalhar com alguns pesquisadores, entre eles Alan Turing, conhecido por criar a Máquina Universal de Turing e Hendrik Wade Bode, conhecido por criar o diagrama de Bode. Enquanto trabalhava, em 1942, formulou uma teoria explicando a comunicação das informações e contribuiu para o estudo do problema sobre como transmitir informação de maneira mais eficiente. Assim, publicou em 1948 seu artigo mais famoso, A Mathematical Theory of Communication.

Conceitos

O trabalho de Shannon enfoca no problema da melhor forma de codificar uma informação que um remetente deseja transmitir, usando ferramentas da teoria da probabilidade.

Abaixo, alguns conceitos que possibilitaram o avanço nas tecnologias de comunicações que temos hoje em dia.

O primeiro é a Informação. Diferente de como é usualmente conhecida, na teoria de Shannon é tida como medida de incerteza.

Podemos usar como exemplo a seguinte situação: Hoje vai chover em Juiz de Fora. Por ser uma cidade de clima tropical, e que possui um alto número de dias com precipitação de chuva, não nos dá muita informação, porque a chuva já é esperada. Já a afirmativa: Hoje vai chover no sertão da Bahia, nos trás mais informação, visto que por ter um clima seco, não se tem muita chuva nessa região, não sendo um evento esperado. Ou seja, quando não sabemos o que esperar, a informação é maior.

A unidade básica de informação é uma situação de “sim-não”. Isso pode ser expressado através da álgebra binária booleana por meio dos números 1 e 0, onde 1 significa “sim” (ou ligado) e 0 significa “não” (ou desligado). Hoje em dia, essa unidade básica é utilizada em todos os computadores do mundo.

O segundo conceito da teoria é a Entropia. Ela é a medida de desordem da informação ou seja, o grau de incerteza, quantificando a quantidade de informação contida em uma mensagem. Quanto maior a informação, maior a desordem, maior a entropia. Quanto menor a informação, menor a escolha, menor a entropia.

Na imagem acima podemos ver o gráfico da entropia pela probabilidade. Percebe-se que a entropia é máxima no caso equiprovável, a probabilidade de dois eventos acontecerem é a mesma, e tende a zero nos extremos. onde não há incerteza.

O próximo conceito é a Informação mútua. Ela nos diz a medida de informação em comum entre duas variáveis aleatórias. Se X for independente de Y, não haverá redução de incerteza, pois não é trazida informação relevante. A informação mútua é então uma ferramenta de grande importância para quantificar independência estatística.

Quando avaliamos a informação mútua entre a entrada de um canal de comunicação e a sua saída, temos condição de avaliar determinados limites para o envio eficiente de mensagens. Esse ponto é simplesmente crucial para a moderna teoria de transmissão de dados.

O último conceito é o da Capacidade. Ela pode ser entendida como uma espécie de “limite de velocidade” para comunicação segura. Caso esse limite seja violado, pode-se ter erros ou falta de segurança nas informações enviadas.

Por outro lado, o teorema diz que, se não tentarmos violar o limite, será possível, em tese, realizar comunicação confiável, desde que a informação seja adequadamente codificada. Muito do que se faz em pesquisa de ponta nas diversas áreas de transmissão de dados gravita em torno de formas de abordar essa tarefa de modo eficiente.

Gostou? Compartilha com os amigos

Por Kássia Carvalho