最近一直在探索RAG相关的技术,并且分析了langchain和llamaindex相关技术实现,现在总结和分享一些自己的经验。

RAG前沿进展

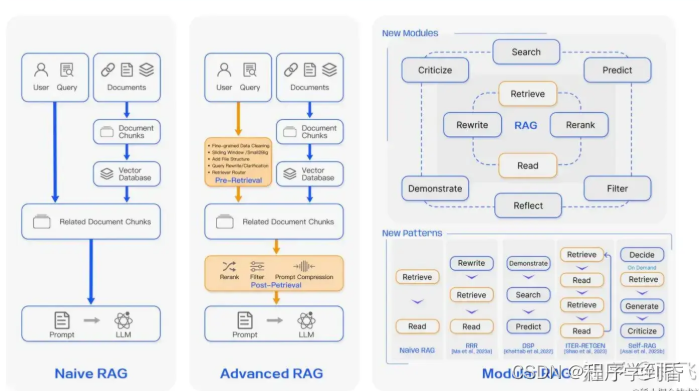

我们借助下面论文中的截图,来说明目前RAG技术的进展。

Retrieval-Augmented Generation for Large Language Models: A Survey

除了在用户的输入query上做文章外,还有更多的操作是进行后处理,比如多路召回和重排序。而且最新的技术也增加了很多新模块,比如 self-RAG 这篇文章就引入了自我性,通过训练一个新的LLM去自适应地按需检索段落,并生成和反映检索到的段落和它自己的生成结果。但这个方法的流程太长,是否适合线上的实际环境,需要真实场景的验证。

从langchain以及llama的实现,以及论文中提及到内容,这次分享RAG的高阶技术分为了三个大模块,

一个是Query Transformation,也就是针对用户query的相关操作,

第二个是Agent技术,本质上利用大模型的能力去调用函数来实现更复杂的功能,

第三个是Post-process 也就是后处理,在我们检索到上下文之后,可以使用一些后处理的方法去对数据进行处理,以便得到更优质的上下文信息。

像重排序、多路召回技术这些都比较常见了,就不再做过多的阐述。

Query Transformation

query transformation 主要就是利用各种技巧和大模型的能力,去对用户的query进行改写,转换等操作,丰富query的语义信息。

Query Rewrite

因为对于 LLM 而言,原始查询不可能总是最佳检索,尤其是在现实世界中,我们首先提示 LLM 重写查询,然后进行检索增强阅读。这个技术可以参考下面langchain中的示例,本质还是使用了提示词工程,去编写改写的提示词,这部分提示词也是可以优化的地方。

python

复制代码

template = """Provide a better search query for \

web search engine to answer the given question, end \

the queries with ’**’. Question: \

{x} Answer:"""

rewrite_prompt = ChatPromptTemplate.from_template(template)

def _parse(text):

return text.strip("**")

distracted_query = "man that sam bankman fried trial was crazy! what is langchain?"

rewriter = rewrite_prompt | ChatOpenAI(temperature=0) | StrOutputParser() | _parse

rewriter.invoke({"x": distracted_query})

MultiQuery

本质上是query rewrite的改进版,可以同时生成n个和用户query相似的query,然后同时进行检索,这样能确保召回的内容尽可能的符合原始query。具体可以参考下面的代码,需要 langchian 的最新版本。

python

复制代码

from langchain.retrievers.multi_query import MultiQueryRetriever

from langchain_openai import ChatOpenAI

question = "What are the approaches to Task Decomposition?"

llm = ChatOpenAI(temperature=0)

retriever_from_llm = MultiQueryRetriever.from_llm(

retriever=vectordb.as_retriever(), llm=llm

)

Hyde

Hyde全称是Hypothetical Document Embeddings,通过LLM对用户的query生成一篇假设性的文档,然后根据这个文档的向量去查找相似的N个向量。 核心的原理就是,生成的假设性文档要比query更接近于embedding 空间。

随着版本的迭代,langchain的文档中对hyde的说明有些变化,从源码中可以看到是内置了多种提示词模板的。

python

复制代码

PROMPT_MAP = {

"web_search": web_search,

"sci_fact": sci_fact,

"arguana": arguana,

"trec_covid": trec_covid,

"fiqa": fiqa,

"dbpedia_entity": dbpedia_entity,

"trec_news": trec_news,

"mr_tydi": mr_tydi,

}

可以参考下面这段代码的实现。

python

复制代码

from langchain_openai import OpenAI

from langchain.embeddings import OpenAIEmbeddings

from langchain.chains import LLMChain, HypotheticalDocumentEmbedder

from langchain.prompts import PromptTemplate

base_embeddings = OpenAIEmbeddings()

llm = OpenAI()

embeddings = HypotheticalDocumentEmbedder.from_llm(llm, base_embeddings, "web_search")

result = embeddings.embed_query("Where is the Taj Mahal?")

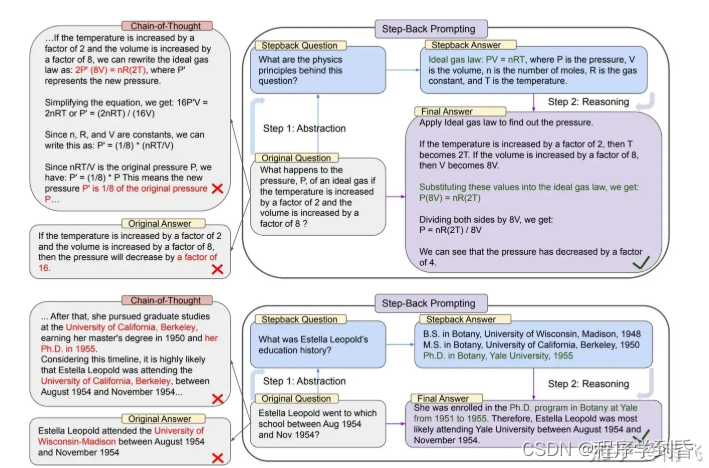

Step-Back Prompt

通过首先回答一个 后退一步 的问题,然后将这个问题检索到的答案和 用户的 QA 对 检索到的信息放在一起,让大模型进行回答。

这个提示词的思路就是,如果一个问题很难回答,则可以首先提出一个能帮助回答这个问题,但是粒度更粗、更简单的问题,下图是Step-Back的提示词的实现思路和介绍。

核心提示词可以参考下面这段代码。

python

复制代码

You are an expert of world knowledge. I am going to ask you a question.

Your response should be comprehensive and not contradicted with the following context if they are relevant.

Otherwise, ignore them if they are not relevant.\n

\n{normal_context}\n

{step_back_context}\n

\nOriginal Question: {question}\n

Answer:

Step-back的提示词可以参考下面这段进行实现和优化。

python

复制代码

You are an expert at world knowledge.

Your task is to step back and paraphrase a question to a more generic step-back question, which is easier to answer.

Here are a few examples:

Agent

核心是利用大模型的Function call功能和提示词工程,去执行一些策略,比如当有多个数据源时,自动选择需要检索的数据源。

Router

当有多个数据源的时候,使用路由技术,将query定位到指定的数据源。可以参考llamaindex的实现,相对比较简单和清晰。

ini

复制代码

from llama_index.tools.types import ToolMetadata

from llama_index.selectors.llm_selectors import (

LLMSingleSelector,

LLMMultiSelector,

)

tool_choices = [

ToolMetadata(

name="covid_nyt",

description=("This tool contains a NYT news article about COVID-19"),

),

ToolMetadata(

name="covid_wiki",

description=("This tool contains the Wikipedia page about COVID-19"),

),

ToolMetadata(

name="covid_tesla",

description=("This tool contains the Wikipedia page about apples"),

),

]

selector_result = selector.select(

tool_choices, query="Tell me more about COVID-19"

)

Post-Process

主要对用户检索之后的上下文进行优化,这里介绍几个比较常用的。

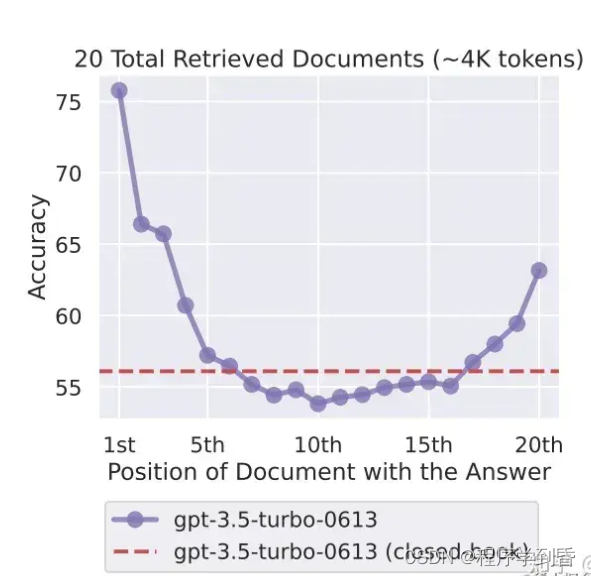

Long-text Reorder

根据论文 Lost in the Middle: How Language Models Use Long Contexts,的实验表明,大模型更容易记忆开头和结尾的文档,而对中间部分的文档记忆能力不强,因此可以根据召回的文档和query的相关性进行重排序。

核心的代码可以参考langchain的实现:

python

复制代码

def _litm_reordering(documents: List[Document]) -> List[Document]:

"""Lost in the middle reorder: the less relevant documents will be at the

middle of the list and more relevant elements at beginning / end.

See: https://arxiv.org/abs//2307.03172"""

documents.reverse()

reordered_result = []

for i, value in enumerate(documents):

if i % 2 == 1:

reordered_result.append(value)

else:

reordered_result.insert(0, value)

return reordered_result

Contextual compression

本质上利用LLM去判断检索之后的文档和用户query的相关性,只返回相关度最高的k个。

ini

复制代码

from langchain.retrievers import ContextualCompressionRetriever

from langchain.retrievers.document_compressors import LLMChainExtractor

from langchain_openai import OpenAI

llm = OpenAI(temperature=0)

compressor = LLMChainExtractor.from_llm(llm)

compression_retriever = ContextualCompressionRetriever(

base_compressor=compressor, base_retriever=retriever

)

compressed_docs = compression_retriever.get_relevant_documents(

"What did the president say about Ketanji Jackson Brown"

)

print(compressed_docs)

Refine

对最后大模型生成的回答进行进一步的改写,保证回答的准确性。主要涉及提示词工程,参考的提示词如下:

vbnet

复制代码

The original query is as follows: {query_str}

We have provided an existing answer: {existing_answer}

We have the opportunity to refine the existing answer (only if needed) with some more context below.

------------

{context_msg}

------------

Given the new context, refine the original answer to better answer the query. If the context isn't useful, return the original answer.

Refined Answer:

Emotion Prompt

同样是提示词工程的一部分,思路来源于微软的论文:

Large Language Models Understand and Can Be Enhanced by Emotional Stimuli

在论文中,微软研究员提出,在提示词中增加一些情绪情感相关的提示,有助于大模型输出高质量的回答。

参考提示词如下:

python

复制代码

emotion_stimuli_dict = {

"ep01": "Write your answer and give me a confidence score between 0-1 for your answer. ",

"ep02": "This is very important to my career. ",

"ep03": "You'd better be sure.",

# add more from the paper here!!

}

# NOTE: ep06 is the combination of ep01, ep02, ep03

emotion_stimuli_dict["ep06"] = (

emotion_stimuli_dict["ep01"]

+ emotion_stimuli_dict["ep02"]

+ emotion_stimuli_dict["ep03"]

)

from llama_index.prompts import PromptTemplate

qa_tmpl_str = """\

Context information is below.

---------------------

{context_str}

---------------------

Given the context information and not prior knowledge, \

answer the query.

{emotion_str}

Query: {query_str}

Answer: \

"""

qa_tmpl = PromptTemplate(qa_tmpl_str)

后记

RAG技术是24年重点发展的技术,优化技术和方式层出不穷,适合自己业务的才是最好的。这篇文章后面会逐步更新最新的研究和技术,感兴趣的可以点赞、收藏。

最后谈几点自己的感悟以及参加一些论坛之后的想法,欢迎一起交流学习。

• 开源社区的功能能到70分的水平,有的企业要求至少90分以上才可用

• 召回率很重要,但有的时候更看重准确率

• 制定适合本场景的评价体系,端到端和分模块评价

• 没有万能的解决方案

如何系统的去学习大模型LLM ?

作为一名热心肠的互联网老兵,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。

但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的 AI大模型资料 包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

😝有需要的小伙伴,可以V扫描下方二维码免费领取🆓

一、全套AGI大模型学习路线

AI大模型时代的学习之旅:从基础到前沿,掌握人工智能的核心技能!

二、640套AI大模型报告合集

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

三、AI大模型经典PDF籍

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。

四、AI大模型商业化落地方案

阶段1:AI大模型时代的基础理解

- 目标:了解AI大模型的基本概念、发展历程和核心原理。

- 内容:

- L1.1 人工智能简述与大模型起源

- L1.2 大模型与通用人工智能

- L1.3 GPT模型的发展历程

- L1.4 模型工程

- L1.4.1 知识大模型

- L1.4.2 生产大模型

- L1.4.3 模型工程方法论

- L1.4.4 模型工程实践 - L1.5 GPT应用案例

阶段2:AI大模型API应用开发工程

- 目标:掌握AI大模型API的使用和开发,以及相关的编程技能。

- 内容:

- L2.1 API接口

- L2.1.1 OpenAI API接口

- L2.1.2 Python接口接入

- L2.1.3 BOT工具类框架

- L2.1.4 代码示例 - L2.2 Prompt框架

- L2.2.1 什么是Prompt

- L2.2.2 Prompt框架应用现状

- L2.2.3 基于GPTAS的Prompt框架

- L2.2.4 Prompt框架与Thought

- L2.2.5 Prompt框架与提示词 - L2.3 流水线工程

- L2.3.1 流水线工程的概念

- L2.3.2 流水线工程的优点

- L2.3.3 流水线工程的应用 - L2.4 总结与展望

- L2.1 API接口

阶段3:AI大模型应用架构实践

- 目标:深入理解AI大模型的应用架构,并能够进行私有化部署。

- 内容:

- L3.1 Agent模型框架

- L3.1.1 Agent模型框架的设计理念

- L3.1.2 Agent模型框架的核心组件

- L3.1.3 Agent模型框架的实现细节 - L3.2 MetaGPT

- L3.2.1 MetaGPT的基本概念

- L3.2.2 MetaGPT的工作原理

- L3.2.3 MetaGPT的应用场景 - L3.3 ChatGLM

- L3.3.1 ChatGLM的特点

- L3.3.2 ChatGLM的开发环境

- L3.3.3 ChatGLM的使用示例 - L3.4 LLAMA

- L3.4.1 LLAMA的特点

- L3.4.2 LLAMA的开发环境

- L3.4.3 LLAMA的使用示例 - L3.5 其他大模型介绍

- L3.1 Agent模型框架

阶段4:AI大模型私有化部署

- 目标:掌握多种AI大模型的私有化部署,包括多模态和特定领域模型。

- 内容:

- L4.1 模型私有化部署概述

- L4.2 模型私有化部署的关键技术

- L4.3 模型私有化部署的实施步骤

- L4.4 模型私有化部署的应用场景

学习计划:

- 阶段1:1-2个月,建立AI大模型的基础知识体系。

- 阶段2:2-3个月,专注于API应用开发能力的提升。

- 阶段3:3-4个月,深入实践AI大模型的应用架构和私有化部署。

- 阶段4:4-5个月,专注于高级模型的应用和部署。

这份完整版的大模型 LLM 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

😝有需要的小伙伴,可以Vx扫描下方二维码免费领取🆓

776

776

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?