La nueva tecnología de Synthesia es impresionante, pero plantea grandes interrogantes sobre un mundo en el que cada vez es más difícil saber qué es real.

Estoy estresada y llego tarde, porque ¿qué te pones para el resto de la eternidad?

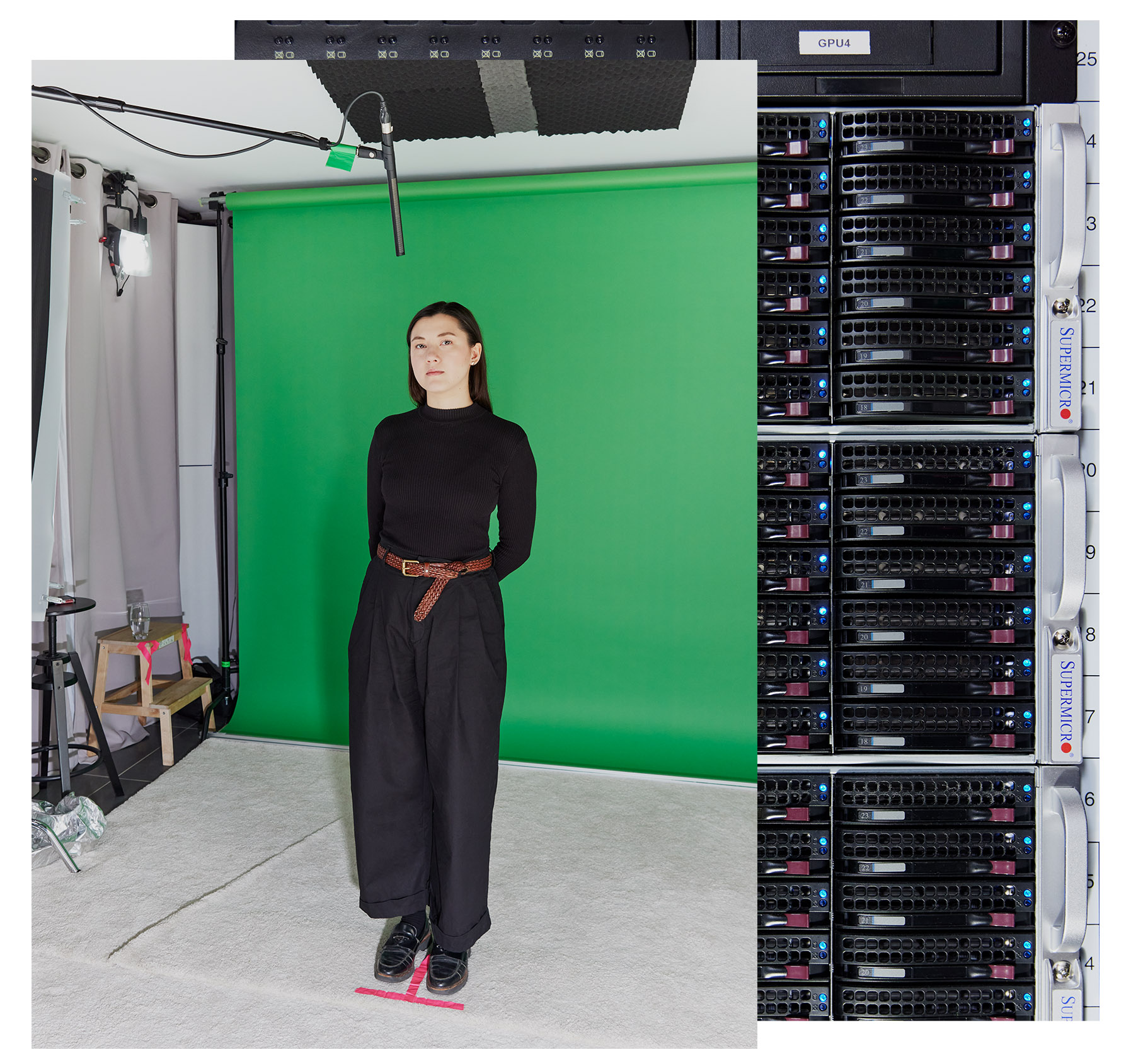

Dicho así, parece que me estoy muriendo, pero es todo lo contrario. En cierto modo, estoy a punto de vivir para siempre, gracias Synthesia, una empresa de vídeos de inteligencia artificial. Durante los últimos años, la empresa ha producido avatares generados por IA, pero hoy lanza una nueva generación, la primera que aprovecha los últimos avances en IA generativa, y son más realistas y expresivos que cualquier cosa que haya visto nunca. Aunque el lanzamiento de hoy significa que casi todo el mundo podrá crear un doble digital, en esta tarde de principios de abril, antes de que la tecnología se haga pública, han accedido a crear uno de mí.Cuando por fin llego al elegante estudio de la empresa en el este de Londres, me recibe Tosin Oshinyemi, jefe de producción de la empresa. Va a guiarme y dirigirme a través del proceso de recopilación de datos -y por "recopilación de datos" me refiero a la captura de mis rasgos faciales, gestos y demás-, como suele hacer con los actores y los clientes de Synthesia.

En este vídeo generado por inteligencia artificial, la Melissa sintética interpreta el famoso soliloquio de Hamlet. (La revista no ha participado en la producción de este vídeo).

Me presenta a un estilista y a un maquillador, y me maldigo por haber perdido tanto tiempo preparándome. Su trabajo consiste en asegurarse de que la gente lleva el tipo de ropa que queda bien ante la cámara y que su aspecto es el mismo en todas las tomas. El estilista me dice que mi atuendo está bien (uf), y el maquillador me retoca la cara y arregla mis caracolillos. El camerino está decorado con cientos de Polaroids sonrientes de personas que han sido clonadas digitalmente antes que yo.

Aparte del pequeño superordenador que zumba en el pasillo, que procesa los datos generados en el estudio, esto se parece más a entrar en un estudio de noticias que a entrar en una fábrica de deepfakes.

Bromeo diciendo que Oshinyemi tiene lo que MIT Technology Review podría llamar un puesto de trabajo del futuro: "director de creación de deepfakes".

"Nos gusta el término «vídeos sintéticos» (synthetic media) en contraposición a «deepfake» ", dice.

Es una diferencia semántica sutil, pero, según algunos, notable. Ambos se refieren a vídeos o grabaciones de audio generados por IA de personas que hacen o dicen algo que no ha ocurrido necesariamente en la vida real. Pero los deepfakes tienen mala reputación. Desde su creación hace casi una década, el término se ha convertido en sinónimo de algo poco ético, afirma Alexandru Voica, responsable de asuntos corporativos y política de Synthesia. Pensemos en contenidos sexuales producidos sin consentimiento o en campañas políticas que difunden desinformación o propaganda.

"Los medios sintéticos son su versión más benigna y productiva", afirma. Y Synthesia quiere ofrecer la mejor versión de esa versión.

Hasta ahora, todos los vídeos de personas generados por IA solían tener cierta rigidez, fallos u otros elementos antinaturales que los hacían muy fáciles de diferenciar de la realidad. Al parecerse tanto a la realidad, pero sin llegar a serlo del todo, estos vídeos pueden resultar molestos, incómodos o desagradables. Synthesia afirma que su nueva tecnología nos sacará por fin de ese valle.

Gracias a los rápidos avances de la IA generativa y a un exceso de datos de entrenamiento creados por actores humanos que se han introducido en su modelo de IA, Synthesia ha sido capaz de producir avatares más parecidos a los humanos y más expresivos que sus predecesores. Los clones digitales son más capaces de adaptar sus reacciones y entonación al sentimiento de sus guiones: por ejemplo, se muestran más optimistas cuando hablan de cosas alegres y más serios o tristes cuando hablan de cosas desagradables. También se adaptan mejor a las expresiones faciales, pequeños movimientos que hablan por nosotros sin necesidad de palabras.

Pero este progreso tecnológico también señala un cambio social y cultural mucho mayor. Cada vez más, gran parte de lo que vemos en nuestras pantallas está generado (o al menos manipulado) por la IA, y cada vez es más difícil distinguir lo que es real de lo que no lo es. Esto amenaza nuestra confianza en todo lo que vemos, lo que podría tener consecuencias muy reales y peligrosas.

"Creo que quizá tengamos que decir adiós a conocer la verdad de forma rápida", afirma Sandra Wachter, profesora del Oxford Internet Institute, que investiga las implicaciones legales y éticas de la IA. "La idea de que puedes buscar algo rápidamente en Google y saber qué es realidad y qué es ficción... no creo vaya a seguir siendo así".

Tosin Oshinyemi, jefe de producción de la empresa, guía y dirige a los actores y clientes durante el proceso de recogida de datos.

Así que, aunque me entusiasmó la idea de que Synthesia creara mi doble digital, también me pregunté si la distinción entre vídeos sintéticos y deepfakes carece fundamentalmente de sentido. Aunque los primeros se centran en la intención del creador y, sobre todo, en el consentimiento del sujeto, ¿existe realmente una forma segura de crear avatares de IA si el resultado final es el mismo? ¿Y realmente queremos salir del valle inquietante si eso significa que ya no podemos captar la verdad?

Pero lo más urgente era averiguar qué se siente al ver una versión posverdadera de uno mismo.

Casi real

Un mes antes de mi viaje al estudio, visité a Victor Riparbelli, CEO de Synthesia, en su oficina cerca de Oxford Circus. Según cuenta Riparbelli, el origen de Synthesia se remonta a sus experiencias explorando la música tecno vanguardista y friki mientras crecía en Dinamarca. Internet le permitió descargarse programas y producir sus propias canciones sin necesidad de comprar caros sintetizadores.

"Soy un gran partidario de dar a la gente la posibilidad de expresarse como pueda, porque creo que así se crea un mundo más meritocrático", me dice.

Vio la posibilidad de hacer algo parecido con el vídeo cuando se topó con una investigación sobre el uso del deep learning (aprendizaje profundo) para transferir expresiones de un rostro humano a otro en la pantalla.

"Fue la primera vez que una red de deep learning podía producir fotogramas de vídeo que parecían reales", explica.

Esa investigación fue realizada por Matthias Niessner, profesor de la Universidad Técnica de Múnich (Alemania), que cofundó Synthesia con Riparbelli en 2017, junto con la profesora del University College de Londres (Reino Unido) Lourdes Agapito y Steffen Tjerrild, con quien Riparbelli había trabajado anteriormente en un proyecto de criptomonedas.

Inicialmente, la empresa construyó herramientas de sincronización labial y doblaje para la industria del entretenimiento, pero descubrió que el listón de calidad de esta tecnología era muy alto y no había mucha demanda. Synthesia cambió de rumbo en 2020 y lanzó su primera generación de avatares de IA para clientes corporativos. El giro dio sus frutos. En 2023, Synthesia alcanzó el estatus de unicornio, lo que significa que fue valorada en más de mil millones de dólares, siendo una de las relativamente pocas empresas europeas de IA en conseguirlo.

La primera generación de avatares parecía tosca, con movimientos en bucle y poca variación. Las iteraciones posteriores empezaron a parecer más humanas, pero aún les costaba decir palabras complicadas y las cosas estaban ligeramente desincronizadas.

El problema es que la gente está acostumbrada a ver las caras de los demás. "Los humanos sabemos lo que hacen los humanos de verdad", afirma Jonathan Starck, CTO de Synthesia. Desde la infancia, "estamos muy acostumbrados a la gente y a las caras. Sabes lo que es correcto, así que cualquier cosa que no lo sea salta a la vista".

Estos primeros vídeos generados por IA, al igual que los deepfakes en general, se crearon utilizando redes generativas adversariales (GAN, por sus siglas en inglés), una técnica más antigua para generar imágenes y vídeos que utiliza dos redes neuronales que dialogan entre sí. Era un proceso laborioso y complicado, y la tecnología era inestable.

Pero con el auge de la IA generativa el año pasado, la empresa ha descubierto que puede crear avatares mucho mejores utilizando redes neuronales generativas que producen mayor calidad de una forma más constante. Cuantos más datos reciben estos modelos, mejor aprenden. Para ello, Synthesia utiliza tanto grandes modelos lingüísticos como modelos de difusión; los primeros ayudan a los avatares a reaccionar al guion, y los segundos generan los píxeles.

A pesar del salto cualitativo, la empresa aún no se ha lanzado a la industria del entretenimiento. Synthesia sigue considerándose una plataforma para empresas. Su apuesta es la siguiente: Como la gente pasa más tiempo viendo vídeos en YouTube y TikTok, habrá más demanda de contenidos de vídeo. Los jóvenes ya se saltan las búsquedas tradicionales y recurren por defecto a TikTok en busca de información presentada en forma de vídeo. Riparbelli afirma que la tecnología de Synthesia podría ayudar a las empresas a convertir sus tediosos informes, comunicaciones corporativas y materiales de formación en contenidos que la gente realmente vea y con los que se comprometa. También sugiere que podría utilizarse para elaborar materiales de marketing.

Afirma que la tecnología de Synthesia es utilizada por el 56% de las empresas incluidas en la lista Fortune 100, y que la gran mayoría de ellas la utilizan para la comunicación interna. La empresa cuenta entre sus clientes a Zoom, Xerox, Microsoft y Reuters. Los servicios cuestan a partir de 22 dólares al mes.

La empresa espera que sea una alternativa más barata y eficaz al vídeo de una productora profesional, y que sea casi indistinguible de éste. Riparbelli me dice que sus avatares más recientes podrían engañar fácilmente a una persona haciéndole creer que son reales.

"Creo que lo hemos conseguido en un 98%", afirma.

Para bien o para mal, estoy a punto de comprobarlo.

No seas basura

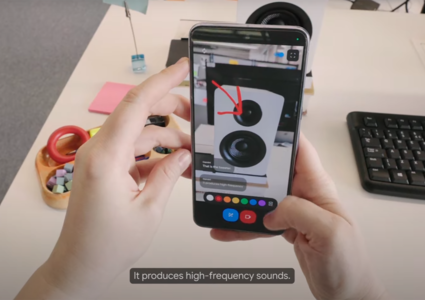

En la investigación de IA hay un dicho: basura que entra, basura que sale. "Cuantos más puntos de datos haya capturado el modelo de IA de mis movimientos faciales, microexpresiones, inclinaciones de cabeza, parpadeos, encogimientos de hombros y saludos con la mano, más realista será el avatar.

De vuelta en el estudio, me esfuerzo por no ser basura.

Estoy delante de una pantalla verde y Oshinyemi me guía por el proceso de calibración inicial, en el que tengo que mover la cabeza y luego los ojos en un movimiento circular. Al parecer, esto permitirá al sistema entender mis colores naturales y mis rasgos faciales. Luego me piden que diga la frase "Todos los niños comieron un pescado", que captará todos los movimientos de la boca necesarios para formar vocales y consonantes. También me graban en silencio.

Cuantos más datos tenga el sistema de IA sobre movimientos faciales, microexpresiones, inclinaciones de cabeza, parpadeos, encogimientos de hombros y saludos con la mano, más realista será el avatar.

A continuación, me pide que lea un guion para una YouTuber ficticia en diferentes tonos, orientándome sobre el espectro de emociones que debo transmitir. Primero debo leerlo de forma neutral e informativa, luego de forma alentadora, molesta y quejumbrosa y, por último, emocionada y convincente.

"Hola a todos: Bienvenidos de nuevo a Elevate Her (elévala) con vuestra presentadora, Jess Mars. Es un placer teneros aquí. Estamos a punto de abordar un tema bastante delicado y que sinceramente nos toca muy de cerca: cómo afrontar las críticas en nuestro camino espiritual", leí en el teleprompter, mientras intentaba visualizar cómo despotricaba de algo ante mi compañera durante la versión quejica. "Mires donde mires, parece que siempre hay una voz crítica dispuesta a intervenir, ¿verdad?"

No seas basura, no seas basura, no seas basura.

"Esa estuvo muy bien. Te estaba viendo y pensaba: «Parece que es real. Definitivamente se está quejando»", dice Oshinyemi, animado. Sugiere que la próxima vez añadamos algo de juicio.

Rodamos varias tomas con distintas variaciones del guion. En algunas versiones puedo mover las manos. En otras, Oshinyemi me pide que sostenga un alfiler de metal entre los dedos mientras lo hago. Se trata de poner a prueba los "bordes" de las capacidades de la tecnología a la hora de comunicarse con las manos, dice Oshinyemi.

Históricamente, conseguir que los avatares de IA parezcan naturales y que los movimientos de la boca se correspondan con el habla ha sido un reto muy difícil, afirma David Barber, profesor de aprendizaje automático del University College de Londres (Reino Unido) que no participa en los trabajos de Synthesia. Esto se debe a que el problema va mucho más allá de los movimientos de la boca: hay que pensar en las cejas, todos los músculos de la cara, los encogimientos de hombros y los numerosos pequeños movimientos que los humanos utilizan para expresarse.

El proceso de captura del movimiento utiliza patrones de referencia para ayudar a alinear las secuencias capturadas desde múltiples ángulos alrededor del sujeto.

Synthesia ha trabajado con actores para entrenar a sus modelos desde 2020, y sus dobles componen los 225 avatares de stock que están disponibles para que los clientes los animen con sus propios guiones. Pero para entrenar a su última generación de avatares, Synthesia necesitaba más datos; ha pasado el último año trabajando con alrededor de 1.000 actores profesionales en Londres y Nueva York. (Synthesia afirma que no vende los datos que recopila, aunque sí cede parte de ellos con fines de investigación académica).

Antes, los actores cobraban cada vez que se utilizaba su avatar, pero ahora la empresa les paga por adelantado para entrenar el modelo de inteligencia artificial. Synthesia utiliza sus avatares durante tres años, tras los cuales se pregunta a los actores si desean renovar sus contratos. En caso afirmativo, acuden al estudio para crear un nuevo avatar. En caso contrario, la empresa elimina sus datos. Los clientes empresariales de Synthesia también pueden generar sus propios avatares enviando a alguien al estudio para que haga gran parte de lo que yo estoy haciendo.

Entre toma y toma, el maquillador viene y me hace algunos retoques para asegurarse de que tengo el mismo aspecto en todas las tomas. Siento que me ruborizo por las luces del estudio, pero también por la actuación. Después de que el equipo haya recogido todas las tomas que necesita para captar mis expresiones faciales, bajo a leer más texto en voz alta para las muestras de voz.

Este proceso requiere que lea un pasaje que indica que consiento explícitamente que clonen mi voz y que ésta pueda utilizarse en la cuenta de Voica en la plataforma Synthesia para generar vídeos y discursos.

El consentimiento es clave

Este proceso es muy diferente de la forma en que se crean muchos avatares de IA, deepfakes o vídeos sintéticos, como quieras llamarlos.

La mayoría de los deepfakes no se crean en un estudio. Las investigaciones han demostrado que la gran mayoría de los deepfakes en internet son contenidos sexuales no consentidos, que suelen utilizar imágenes robadas de las redes sociales. La IA generativa ha hecho que la creación de estos deepfakes sea fácil y barata, y ha habido varios casos sonados en EE UU y Europa de niños y mujeres que han sufrido abusos de este tipo. Los expertos también han alertado de que la tecnología puede utilizarse para difundir desinformación política, una amenaza especialmente grave dado el número récord de elecciones que se celebran este año en todo el mundo.

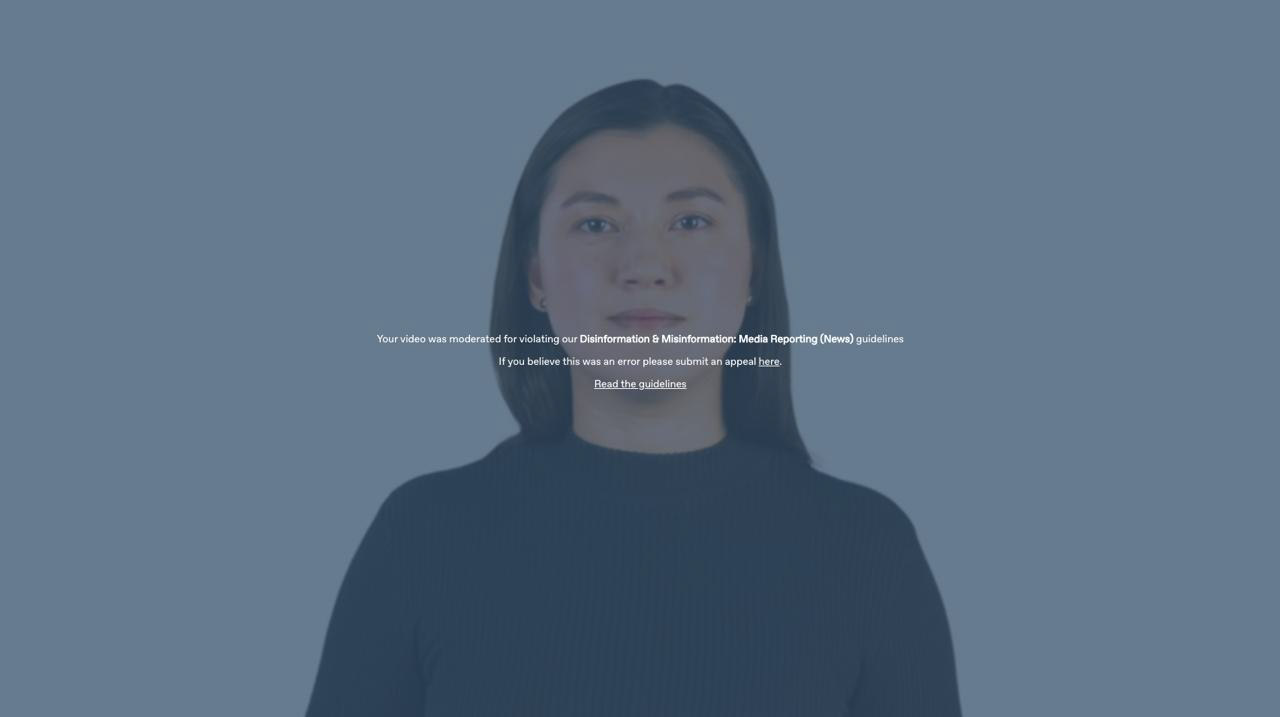

La política de Synthesia es no crear avatares de personas sin su consentimiento explícito. Pero no ha sido inmune a los abusos. El año pasado, unos investigadores descubrieron información falsa a favor de China creada con avatares de Synthesia y empaquetada como noticias, lo que, según la empresa, infringía sus condiciones de servicio.

Desde entonces, la empresa ha puesto en marcha sistemas más rigurosos de verificación y moderación de contenidos. Aplica una marca de agua con información sobre dónde y cómo se crearon los vídeos con avatares de IA. Si antes contaba con cuatro moderadores de contenidos internos, ahora las personas que realizan este trabajo representan el 10% de su plantilla de 300 personas. También ha contratado a un ingeniero para crear mejores sistemas de IA de moderación de contenido. Estos filtros ayudan a Synthesia a examinar todo lo que sus clientes intentan generar. Cualquier cosa sospechosa o ambigua, como contenidos sobre criptomonedas o salud sexual, se reenvía a los moderadores de contenidos humanos. Synthesia también lleva un registro de todos los vídeos que crea su sistema.

Y aunque cualquiera puede unirse a la plataforma, muchas funciones no están disponibles hasta que se pasa por un exhaustivo sistema de selección similar al utilizado en el sector bancario, que incluye hablar con el equipo de ventas, firmar contratos legales y someterse a auditorías de seguridad, explica Voica. Los clientes de nivel básico están limitados a producir contenidos estrictamente objetivos, y sólo los clientes empresariales que utilizan avatares personalizados pueden generar contenidos que contengan opiniones. Además, sólo las organizaciones de noticias acreditadas pueden crear contenidos sobre temas de actualidad.

"No podemos pretender ser perfectos. Si la gente nos informa de cosas, tomamos medidas rápidas, [como] prohibir o limitar a personas u organizaciones", dice Voica. Pero cree que estas medidas funcionan como elemento disuasorio, lo que significa que la mayoría de los malos actores recurrirán en su lugar a herramientas de código abierto disponibles gratuitamente.

Pongo a prueba algunos de estos límites cuando me dirijo a la oficina de Synthesia para el siguiente paso en el proceso de generación de mi avatar. Para crear los vídeos en los que aparecerá mi avatar, tengo que escribir un guion. Utilizando la cuenta de Voica, decido utilizar pasajes de Hamlet, así como artículos anteriores que he escrito. También utilizo una nueva función de la plataforma Synthesia, un asistente de inteligencia artificial que transforma cualquier enlace web o documento en un guion listo para usar. Intento que mi avatar lea noticias sobre las nuevas sanciones de la Unión Europea contra Irán.

Voica me envía inmediatamente un mensaje de texto: "¡Me has metido en un lío! ".

El sistema ha marcado su cuenta por intentar generar contenidos restringidos.

Los filtros de contenidos basados en IA ayudan a Synthesia a examinar todo lo que sus clientes intentan generar. Sólo las organizaciones de noticias acreditadas pueden crear contenidos sobre temas de actualidad.

Ofrecer servicios sin estas restricciones sería "una gran estrategia de crecimiento", refunfuña Riparbelli. Pero "en última instancia, tenemos normas muy estrictas sobre lo que se puede crear y lo que no. Creemos que la forma correcta de desplegar estas tecnologías en la sociedad es ser un poco demasiado restrictivos al principio".

Aun así, aunque estos guardarraíles funcionaran a la perfección, el resultado final seguiría siendo un internet en el que todo es falso. Y mi experimento me hace preguntarme cómo podríamos prepararnos.

Nuestro panorama informativo ya parece muy turbio. Por un lado, la opinión pública es cada vez más consciente de que los contenidos generados por inteligencia artificial están floreciendo y podrían ser una poderosa herramienta de desinformación. Pero, por otro, aún no está claro si los deepfakes se utilizan para desinformar a gran escala y si están moviendo la aguja para cambiar las creencias y los comportamientos de las personas.

Si la gente se vuelve demasiado escéptica sobre los contenidos que ve, podría dejar de creer en nada, lo que permitiría a los malos actores aprovecharse de este vacío de confianza y mentir sobre la autenticidad de los contenidos reales. Los investigadores han llamado a esto el "dividendo del mentiroso". Advierten de que los políticos, por ejemplo, podrían afirmar que una información realmente incriminatoria era falsa o creada mediante IA.

Claire Leibowicz, responsable de la integridad de la IA y los medios de comunicación de la organización sin ánimo de lucro Partnership on AI, teme que la creciente concienciación sobre esta brecha facilite "negar de forma plausible y poner en duda material o medios reales como prueba en muchos contextos diferentes, no sólo en las noticias, [sino] también en los tribunales, en el sector de los servicios financieros y en muchas de nuestras instituciones". Me dice que se siente alentada por los recursos que Synthesia ha dedicado a la moderación de contenidos y al consentimiento, pero afirma que ese proceso nunca es perfecto.

Incluso Riparbelli admite que, a corto plazo, la proliferación de contenidos generados por IA probablemente causará problemas. Aunque se ha enseñado a la gente a no creer todo lo que lee, sigue confiando en las imágenes y los vídeos, añade. En su opinión, ahora hay que probar los productos de IA por uno mismo para ver lo que es posible, y no fiarse de nada de lo que se vea en internet a menos que se haya verificado.

No hay que olvidar que la regulación de la IA es aún incompleta y que los esfuerzos del sector tecnológico por verificar la procedencia de los contenidos están aún en sus primeras fases. ¿Pueden los consumidores, con sus diversos grados de alfabetización mediática, luchar realmente contra la creciente ola de contenidos nocivos generados por IA mediante la acción individual?

Cuidado, PowerPoint

Al día siguiente de mi última visita, Voica me envía por correo electrónico los vídeos con mi avatar. Cuando empieza a reproducirse el primero, me quedo perpleja. Es tan doloroso como verse a uno mismo delante de una cámara o escuchar una grabación de su voz. Entonces me doy cuenta. Al principio pensé que el avatar era yo.

Cuanto más veo los vídeos de "mí misma", más suspiro. ¿De verdad entrecierro tanto los ojos? ¿Parpadeo tanto? ¿Y muevo la mandíbula así? Por Dios.

Es bueno. Es realmente bueno. Pero no es perfecto. "Una animación extrañamente buena", me manda un mensaje mi compañero.

"Pero la voz a veces suena exactamente como tú, y otras veces como una americana genérica y con un tono raro", añade. "Es raro de narices".

Y tiene razón. La voz a veces soy yo, pero en la vida real hago más umm y ehh. Lo sorprendente es que detectó una irregularidad en mi forma de hablar. Mi acento es un lío transatlántico, confundido por años de vivir en el Reino Unido, ver la televisión estadounidense y asistir a una escuela internacional. Mi avatar a veces dice la palabra "robot" con acento británico y otras veces con acento americano. Es algo que probablemente nadie más notaría. Pero la IA sí.

La gama de emociones de mi avatar también es limitada. Pronuncia el discurso de Shakespeare "Ser o no ser" con mucha naturalidad. Lo había guiado para que se enfureciera al leer una historia que escribí sobre los deepfakes de desnudos no consentidos de Taylor Swift; el avatar se queja y juzga, sin duda, pero no se enfada.

No es la primera vez que me convierto en sujeto de pruebas para una nueva IA. No hace mucho, intenté generar imágenes de avatares míos para la IA, pero me salieron un montón de desnudos. Aquella experiencia fue un ejemplo chocante de lo parciales que pueden ser los sistemas de IA. Pero esta experiencia -y esta forma concreta de ser inmortalizada- se sitúa definitivamente en otro nivel.

Carl Öhman, profesor adjunto de la Universidad de Uppsala (Suecia) que ha estudiado restos digitales y es autor de un nuevo libro, The Afterlife of Data (El ultratumba de los datos), llama a los avatares como los que hice "cadáveres digitales".

"Se parece exactamente a ti, pero no hay nadie en casa", dice. «Sería el equivalente a clonarte, pero tu clon está muerto. Y entonces animas el cadáver, para que se mueva y hable, con impulsos eléctricos».

Eso es más o menos lo que se siente. Los pequeños matices con los que no me reconozco son suficientes para que me dé cuenta. Por otra parte, es muy posible que el avatar engañe a cualquiera que no me conozca muy bien. El avatar brilla cuando presenta una historia que escribí sobre cómo el campo de la robótica podría estar teniendo su propio momento ChatGPT; el asistente virtual de IA resume la larga lectura en un vídeo corto decente, que mi avatar narra. No es Shakespeare, pero es mejor que muchas de las presentaciones corporativas a las que he tenido que asistir. Creo que, si lo utilizara para presentar un informe de fin de año a mis colegas, tal vez ese nivel de autenticidad sería suficiente.

Y eso es lo que vende, según Riparbelli: "Lo que hacemos se parece más a PowerPoint que a Hollywood".

Una vez generado el parecido, Synthesia es capaz de generar presentaciones de vídeo rápidamente a partir de un guión. En este vídeo, la «Melissa» sintética resume un artículo que la Melissa real escribió sobre los deepfakes de Taylor Swift.

La última generación de avatares no está preparada para la gran pantalla. Siguen atrapados en el modo retrato y sólo muestran al avatar de frente y de cintura para arriba. Pero en un futuro no muy lejano, dice Riparbelli, la empresa espera crear avatares que puedan comunicarse con las manos y mantener conversaciones entre ellos. También planea crear avatares de cuerpo entero que puedan caminar y moverse por un espacio generado por una persona. (El equipo que permite esta tecnología ya existe; de hecho, es donde estoy en la imagen que encabeza este artículo).

Pero, ¿realmente queremos eso? Parece un futuro sombrío en el que los humanos consumen contenidos generados por la IA que les presentan avatares generados por la IA y utilizan la IA para reempaquetarlos en más contenidos, que probablemente serán desechados para generar más IA. Por lo menos, este experimento me ha dejado claro que el sector tecnológico necesita urgentemente mejorar sus prácticas de moderación de contenidos y asegurarse de que las técnicas de procedencia de los contenidos, como las marcas de agua, sean sólidas.

Aunque la tecnología y la moderación de contenidos de Synthesia aún no son perfectas, son mucho mejores que cualquier otra cosa que haya visto antes en este campo, y eso que sólo ha transcurrido un año del auge actual de la IA generativa. El desarrollo de la IA avanza a una velocidad de vértigo, y resulta a la vez emocionante y desalentador pensar en cómo serán los avatares de la IA dentro de unos pocos años. Quizá en el futuro tengamos que adoptar palabras seguras para indicar que nos estamos comunicando con un ser humano real, no con una IA.

Pero ese día no es hoy.

Me resultó extrañamente reconfortante que, en uno de los vídeos, mi avatar despotricara de los deepfakes no consentidos y dijera, con voz sociopáticamente feliz: "¿Los gigantes tecnológicos? Se están forrando".

Yo nunca lo haría.